Server a una profondità di 35 metri

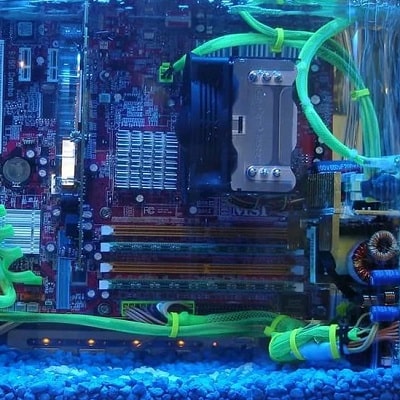

Nel 2020, Microsoft ha annunciato il successo di un progetto, ovvero il test di un data center che funzionava nell’oceano a una profondità di 35 metri. Il server è stato collocato in una grande capsula, che è stata poi immersa nell’acqua.

A cosa serviva?

Molte persone sanno che quando si lavora in una stanza separata, l’attrezzatura diventa molto calda, quindi è necessario un sistema di climatizzazione costoso e di alta qualità.

Ma in questo caso stiamo parlando di raffreddamento naturale. Ma c’è un altro vantaggio qui, dal momento che puoi posizionare i centri più vicini all’utente, quindi questo riduce notevolmente i tempi di elaborazione della richiesta. Le statistiche mostrano che circa la metà della popolazione vive entro 100 chilometri dalla costa. E puoi realizzare tali progetti in soli 3 mesi.

Ma c’è anche un aspetto negativo, nella solita modalità è quasi impossibile servire i progetti. Quindi c’è molta attenzione ai problemi di affidabilità.

Cos’è questo progetto?

I primi test di questo tipo di capsule sono stati effettuati nel 2015. Questa è la prima fase di un nuovo progetto, il cui obiettivo era che il data center potesse funzionare proprio così.

Successivamente, il team doveva confermare che la scalabilità commerciale di questa tecnologia fosse realmente possibile e che tali sistemi potessero funzionare in modo stabile in condizioni reali. Nella primavera del 2018, la capsula fu immersa in acqua a una profondità di 35 metri, dove fu esposta per un lungo periodo a fattori ambientali come variazioni di pressione e cambiamenti di temperatura. Dopo l’installazione, gli specialisti condussero un’ampia serie di test di affidabilità e prestazioni, con l’obiettivo di valutare il comportamento dell’attrezzatura in isolamento dai fattori fisici esterni e senza intervento umano. La capsula ospitava 864 server, e gli ingegneri monitoravano costantemente il loro funzionamento, analizzando la stabilità, l’efficienza energetica e la capacità complessiva dell’infrastruttura di supportare operazioni di dati su larga scala.

Inizialmente, si presumeva che il lavoro sarebbe stato il più produttivo e stabile possibile. A terra bisogna subito tenere conto delle variazioni di temperatura e del fattore umano, dell’ossigeno, dell’umidità e di altri parametri.

E i dati dell’azienda hanno mostrato che il volume dei guasti era 1/8 di centri simili operanti a terra. Il fatto è che la capsula era piena di azoto ed era ermetica. Cioè, questo è l’impatto minimo sull’attrezzatura.